Dem Aufeinandertreffen von menschlicher Kreativität und technischer Perfektion verschreibt sich das erste „AI x Music Festival“, das Ars Electronica und die Europäische Kommission als Teil der STARTS-Initiative ausrichten. Von 6. bis 8. September 2019 versammelt Ars Electronica dafür MusikerInnen, KomponistInnen, KulturhistorikerInnen, TechnologInnen, WissenschaftlerInnen und AI-EntwicklerInnen aus aller Welt in Linz und widmet sich mit Konzerten und Performances, Konferenzen, Workshops und Ausstellungen der Interaktion von Menschen und Maschinen.

Überblick

Mit dabei sind renommierte Persönlichkeiten aus der Kunst wie Hermann Nitsch, Christian Fennesz, Markus Poschner, Dennis Russell Davies, Maki Namekawa, Memo Akten, Anthony Moore oder Sophie Wennerscheid und aus der Wissenschaft wie Josef Penninger, Siegfried Zielinski, Ludger Brümmer oder Hugues Vinet. Ebenfalls mit dabei sind Persönlichkeiten wie Matthias Röder vom Karajan Institut, die Autorin, Theologin, Redakteurin, Filmemacherin und Moderatorin Renata Schmidtkunz oder Amanda Cox von der Data Journalism Section The Upshot der New York Times. Dazu kommen international führende EntwicklerInnen der Yamaha R&D Division AI Group und Glenn Gould Foundation, von Googles Magenta Studio, SonyLab, IRCAM oder den Nokia Bell Labs, auch diverse Start-Ups präsentieren sich.

Schauplätze des „AI x Music Festivals“ sind die Anton Bruckner Privatuniversität, das Ars Electronica Center, der Linzer Donaupark, die POSTCITY und das Stift St. Florian. Letzteres ist der unbestrittene Hotspot des „AI x Music Festivals“: Ob Marmorsaal, Kirche, Krypta oder Gruft – die eindrucksvollen Räumlichkeiten dieses spirituellen Orts bilden einen perfekten Rahmen, um über die künftige Rolle intelligenter Maschinen und unser Selbstverständnis als Menschen nachzudenken.

Programm

Freitag, 6. September 2019 / POSTCITY, Ars Electronica Center

Workshops

Mit einer Reihe von Workshops startet das „AI x Music Festival“ in der POSTCITY. Reeps One (UK) von Nokia Bell Labs legen ihren Fokus auf disruptive Forschungsarbeiten für die nächste Phase in der Menschheitsgeschichte, Jérôme Nika (FR) arbeitet mit ForscherInnen von IRCAM und reflektiert die Rolle der Interaktion von Mensch und Maschine im Kontext der Musik und Daniele Ghisi (IT) lädt zum Workshop „La machine des monstres“. Der Computermusik-Designer, Musiker und Forscher Koray Tahiroğlu (Fl/TR) präsentiert Tools für die Echtzeit-Performance digitaler Musik, die an der Aalto University entwickelt wurden. Im Rahmen des ebenfalls gemeinsam mit der Europäischen Kommission ausgerichteten STARTS-Programms gibt es weitere Lectures, die sich der Verschränkung von AI und Musik widmen.

Performance

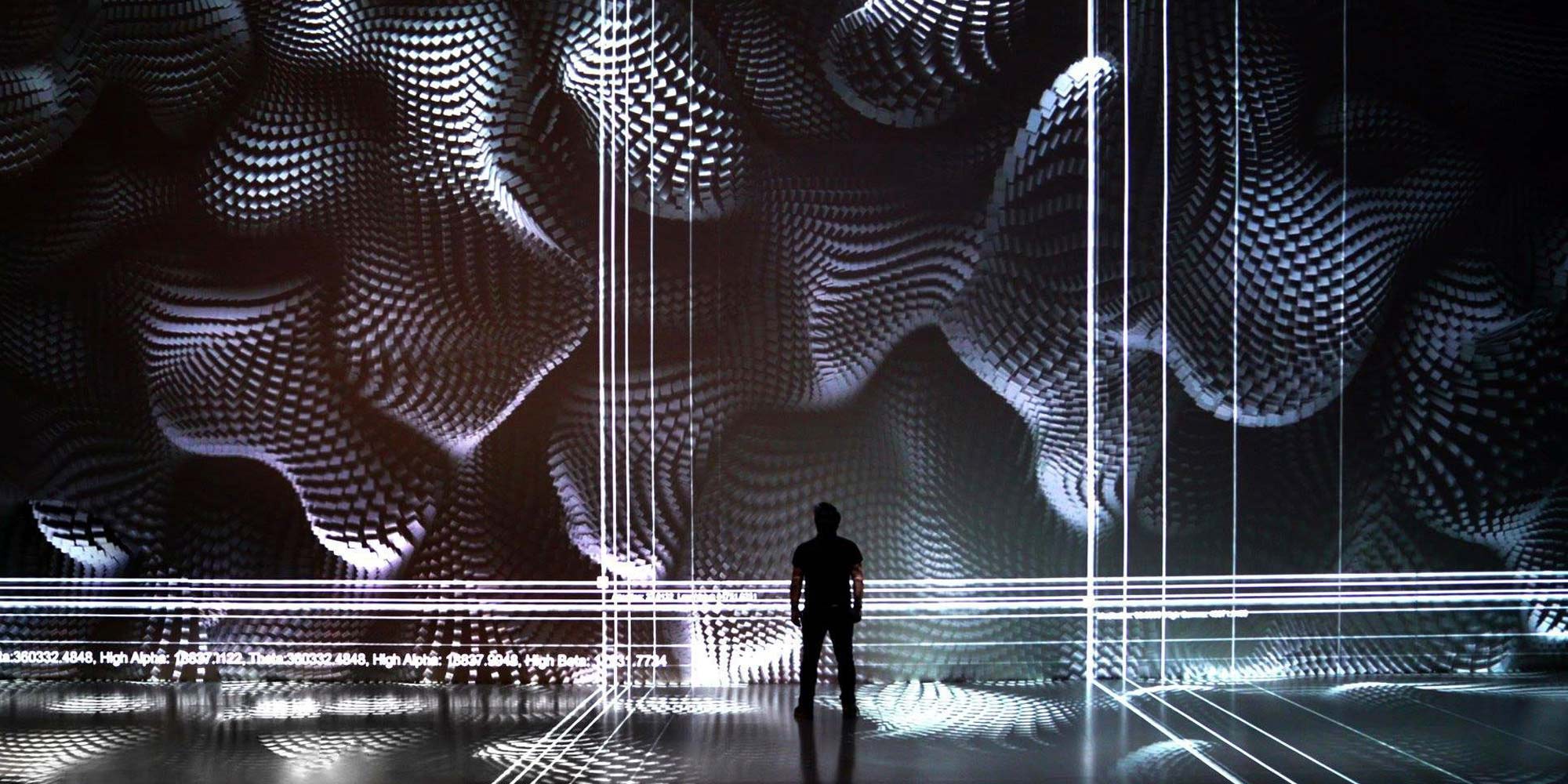

Im Deep Space des Ars Electronica Center präsentieren die Pianistin Kaoru Tashiro (JP) und der digitale bildende Künstler OUCHHH (TR) eine Performance, die Musik und digitale Bilder zu einer faszinierenden Live-Performance verschmelzen lässt.

Große Konzertnacht

Am Abend steht mit der „Großen Konzertnacht“ der diesjährigen Ars Electronica zugleich das Auftaktkonzert des „AI X Music Festivals“ auf dem Programm (und findet daher ausnahmsweise nicht erst am Festival-Sonntag, sondern schon am Freitag statt!). „Mahler-Unfinished – Music meets AI“ lautet der Titel des ambitionierten Konzerts, das in der spektakulären Gleishalle der POSTCITY zur Begegnung von Orchestermusik und elektronischer Musik, menschlichen und robotischen TänzerInnen und Artificial Intelligence gerät. Den Auftakt bestreitet Christian Fennesz (AT) mit „Mahler Remixed“. Der stilprägende Protagonist elektronischer Musik in Österreich nutzt Samples aus Mahler-Symphonien für seine Liveperformance, die Visuals dazu kommen von Lillevan (DE). Gegen Ende dieser Session stößt der Pianist Markus Poschner (DE) dazu und leitet mit seinen Improvisationen von der Elektronik zur Orchestermusik über. Unter dem Dirigenten Poschner bringt das Bruckner Orchester Linz dann Mahlers unvollendete Sinfonie Nr. 10 zur Aufführung. „Unvollendet“ – ein Wort, in dem stets die Auf- und Herausforderung zum Weiterdenken und Neuinterpretieren mitschwingt. Nicht um Mahler zu imitieren oder gar zu verbessern, sondern um mit unseren heutigen künstlerischen Zugängen und technischen Möglichkeiten neue Ausdrucksformen zu erproben. „Mahler Unfinished“ war daher auch der kreative Ausgangspunkt für Ali Nikrang (IR/AT), Pianist, Komponist, Computer-Wissenschaftler, AI-Entwickler und Forscher am Ars Electronica Futurelab. Mit MuseNet, dem derzeit leistungsfähigsten AI-System für musikalische Anwendungen von OpenAI, hat Nikrang das signifikante Bratschenthema am Beginn von Mahlers 10. neu erarbeitet. Vorgegeben wurden dem System dabei nur die ersten zehn Töne der originalen Melodie nebst einiger stilistischer Parameter. Output waren unzähligen Neuinterpretationen, von denen Nikrang eine ausgewählt und ihre Orchestrierung dann wieder von Hand ausgearbeitet hat. Das Ergebnis wird im Rahmen der „Großen Konzertnacht“ vom Bruckner Orchester Linz aufgeführt. Wie schon bei der letzten Großen Konzertnacht wird auch diesmal wieder Silke Grabinger (AT) mit dabei sein: Mittels Motion-Tracking wird ihr Tanz auf Industrieroboter übertragen, die wiederum eine menschengroße Puppe wie eine Marionette tanzen lassen. Mit „Alive painting“ steuert Akiko Nakayama (JP) noch eindrucksvolle Echtzeit-Visualisierung bei. Im zweiten Teil der Großen Konzertnacht betritt dann Ryoichi Kurokawa (JP) die Bühne – seine Performance „subassemblies“ besticht durch die organische Kombination von Bild und Ton. Mit seinen „Sonic Robots“ liefert Moritz Simon Geist (DE) zu guter Letzt noch eine mitreißende Performance mit selbstgebauten robotischen Instrumenten ab. Im Anschluss startet die Ars Electronica Nightline.

Samstag, 7. September 2019 / Anton Bruckner Privatuniversität, Stift St. Florian

Der zweite Tag des “AI x Music Festivals“ startet mit dem von Volkmar Klien (AT) und Andreas Weixler (AT) kuratierten „Sonic Saturday – Medium Sonorum“ in der Anton Bruckner Privatuniversität. Zunächst treten Tobias Leibetseder (AT) & Astrid Schwarz (AT), Tania Rubio (MX) und Erik Nyström (SE) auf, nach der Pause inszenieren Kaori Nishii (JP) und Angélica Castelló (MX/AT) die Performance „Luc Ferrari“.

Vorträge, Gespräche, Demonstrationen, Konzerte

Mittag wechselt das „AI x Music Festival“ dann ins Stift St. Florian. Den ganzen Nachmittag und Abend stehen moderierte Vorträge, Gespräche, Demonstrationen und Konzerte auf dem Programm.

Zum Auftakt gibt Hermann Nitsch (AT) ein Orgelkonzert und spielt dabei nicht irgendein Instrument; die Brucknerorgel der St. Florianer Basilika gilt als eine der prächtigsten in ganz Europa.

Direkt im Anschluss startet die erste prominent besetzte Podiumsdiskussion: Im Gespräch mit Renata Schmidtkunz (AT) widmen sich Josef Penninger (AT) und Sophie Wennerscheid (DE) der Rolle von Wissenschaft und Forschung, die zunächst vor allem ein religiöses Weltbild zu bestätigen hatten, dann der ökonomischen Rationalität untergeordnet wurden und sich nun, im anbrechenden Zeitalter der AI, wieder neu orientieren. Cellistin Yishu Jiang (AT) knüpft mit einer Performance daran an und fragt, welche Voraussetzungen und Strategien für einen reflektierten gesellschaftlichen Diskurs über KI notwendig wären.

Die nächste Session befasst sich mit AI-Anwendungen, die neue künstlerische Möglichkeiten eröffnen. Im Gespräch mit Renata Schmidtkunz (AT) befassen sich François Pachet (FR) und Markus Poschner (DE) mit den damit verbundenen Auswirkungen, etwa neue Geschäftsmodelle oder (urheber-)rechtliche Regelwerke. Gleich danach tritt Weiping Lin (TW) mit der Violine auf.

Weiter geht es mit dem nächsten prominent besetzten Podium: Walter Ötsch (AT) und Marta Peirano (ES) sprechen über die gesellschaftlichen Akzeptanz der aktuellen AI-Forschung.

Das nächste Highlight ist dann „Calculated Sensations“, eine „Expanded Lecture“ mit Siegfried Zielinski (DE), Europas führendem Experten für Medienarchäologie und Kulturgeschichte der Maschinen, und Anthony Moore (UK), britischer Experimentalmusiker, Komponist, Produzent und Mitautor von Pink Floyd-Songs. Die beiden laden zur Zeitreise durch vier Jahrtausende Musikgeschichte. An sieben verschiedenen Locations des Stifts St. Florian wird dabei jeweils ein Schwerpunktthema bearbeitet – mit kurzen Texten, experimentellen Klängen und Dialogen.

Weiter geht es mit vier „Conversations on AI“ und zwei „Reports and Proceedings“: Vladan Joler (RS) und Vuk Ćosić (SI) unterhalten sich über die Beziehung von Geisteswissenschaften und Künstlicher Intelligenz früher und heute, Aza Raskin (US) und Maja Smrekar (SI) befassen sich mit den Parallelen und Gemeinsamkeiten der künstlerischen Praxis in AI und Life Art. Markus Poschner (DE) und Ali Nikrang (IR/AT) widmen sich den Aspekten Komposition, Interpretation, Reproduktion und Rezeption. Marta Peirano (ES) fragt nach dem Spannungsverhältnis von Information und Desinformation im Zeitalter von AI, Clara Blume (AT) und Naut Humon (US) wiederum geben Einblick in die AI & Music Szene in der Bay Area und Lynn Hughes (CA) fragen sich, ob die Soundtracks aktueller AI-Systeme den Ansprüchen der Gaming-Industrie genügen.

Die nächsten Sessions setzen sich aus Talks und Performances zusammen, die allesamt aktuelle AI-Applikationen zum Thema haben. Zunächst befassen sich Dennis Russell Davies (US/AT), Maki Namekawa (JP/AT) und Francesco Tristano (LU) mit dem Spannungsverhältnis von Originalität und Authentizität bei der Bewertung von AI-generierter Musik. Akira Maezawa (JP) und Brian M. Levin (CA) präsentieren ein Forschungsprojekt von Yamaha und der Glenn Gould Foundation, bei dem ein AI-System darauf trainiert wurde, den Interpretationsstil von Glenn Gould exakt nachzuempfinden. Markus Poschner (DE) und Norbert Trawöger (AT) widmen sich Machine Learning-Anwendungen, die auf statistischen Verfahren gründen, deren Ergebnisse auf uns aber dennoch spontan und originell wirken. Ali Nikrang (IR/AT) knüpft daran an und zeigt, wie er mittels MuseNet von OpenAI, das Bratschenthema von Mahlers 10. Symphonie neu erarbeitet hat.

Nächster Programmblock sind Performances und Demonstrationen rund um die AI-unterstützte Kreation von Musik: Tomomi Adachi (JP) nutzt eine Performance-KI namens „Tomomibot“, die aus musikalischen Improvisationen lernt, live mit einem menschlichen Stimmimprovisator zu interagieren. Muku Kobayashi (JP) und Mitsuru Tokisato aka SHOJIKI (JP) geben den völlig analogen Gegenpol und improvisieren nur mit … Klebestreifen! Ausgehend von ihrer gemeinsamen Performance „Ultrachunk“ befasst Memo Akten (TR) mit der Rolle von AI-Anwendungen in Puncto Improvisation. Stiftsorganist Klaus Sonnleitner (AT) lädt zum Konzert und improvisiert auf der Orgel im Geiste Anton Bruckners, danach spielt Roberto Paci Dalò (IT) auf der (Bass-)Klarinette und arbeitet dabei mit der ganz speziellen Akustik des St. Florianer Marmorsaals. Rupert Huber (AT) wiederum nimmt am Klavier Platz und improvisiert ebenfalls.

Ein weiterer Programmblock des „AI x Music Festivals“ sind Demos aktueller AI-Applikationen. Ali Nikrang (IR/AT) diskutiert historische und aktuelle AI-Systeme zum Generieren von Musik – er geht dabei der Frage nach, was musikalische Daten besonders macht und warum ist es eine große Herausforderung Musik mittels AI-Anwendungen zu komponieren. Thomas Grill (AT) und Martina Claussen (AT) führen zahlreiche Experimente zur Verbesserung der Mensch-Maschine-Kommunikation durch. Vittorio Loreto (IT) demonstriert, wie Musik und AI mit Sony CSL zu etwas Neuem verschmelzen, die MusikerInnen von Ensemble Vivante (AT) präsentieren die dramatisch aufgeladene Vokalmusik von Moneteverdi.

Im Mittelpunkt des nächsten Blocks stehen Präsentationen und Diskussionen zu aktuellen AI-Forschungsaktivitäten. Ludger Brümmer (DE) spricht über die transdisziplinäre Forschung am Hertz Lab des ZKM, François Pachet (FR) erläutert seine Forschungen zu „Flow Machines“ wie SKYGGE.

Weiter geht es mit einer ganzen Reihe von Workshops. Memo Akten (TR) zeigt, wie Generative Artificial Neuronal Networks (GANS) als Medium für kreativen Ausdruck und Geschichtenerzählung genutzt werden können. Eine akribische Zusammenstellung aller menschlicher Arbeits-, Daten- und Naturressourcen, die für den Bau und Betrieb eines Amazon Echo erforderlich sind, präsentiert Vladan Joler (RS) vom SHARE Lab mit dem Projekt „Anatomy of an AI-System“.

Abendkonzert

Samstagabend lädt das „AI x Music Festival“ dann zur Zeitreise von den Anfängen der Musikgeschichte bis ins Hier und Heute. Komponist und Organist Wolfgang Mitterer (AT) führt mit seiner LIVE-Performance vor Augen, welch Kraft und Wirkung menschliche AkteurInnen auch in Zeiten immer weitergehender Digitalisierung auf der Bühne entfalten können. Quadrature (DE) wiederum empfangen Signale aus dem Weltraum, die von einem AI-System interpretiert und an ein robotisches Manual aus Elektromagneten weitergeleitet werden, das schließlich die Orgel zum Klingen bringt. Die ExpertInnen der Yamaha R&D Division AI Group, der Glenn Gould Foundation, Francesco Tristano (LU) und MusikerInnen des Bruckner Orchesters steuern eine AI-basierte Performance bei. Krönender Abschluss des Abends ist dann „Heavy Requiem – Buddhist Chant: Shomyo + Electronics“. Keiichiro Shibuya (JP), Eizen Fujiwara (JP) und Justine Emard (FR) lassen traditionelle buddhistische Musik mit elektronischen Klängen verschmelzen.

Ausstellungen

Auch eine Reihe von Kunstprojekten wird in den Räumlichkeiten des Stifts präsentiert: Mit seiner Installation „Anschwellen – Abschwellen“ geht Volkmar Klien (AT) der Frage nach, was eine Maschine autonom, reaktiv und intelligent erscheinen lässt? Das „Akusmonium“ ist ein einzigartiges Lautsprecherorchester zur Interpretation computergenerierter Musik und Kreation von ephemeren, dynamisch bewegten Klangskulpturen. Thomas Gorbach (AT) lädt das Publikum auf diese Weise zur Reise von der Geschichte des elektronischen Klangs über die digitale Klangerzeugung bis hin zu KI-basierten Kompositionen. Stefan Tiefengrabers (AT) “WM_EX10 TCM_200DV TP-VS500 MS-201 BK26 MG10 [INSTALLATION/PERFORMANCE]” ist eine Installation und Performance, bei der unerwartete und unkontrollierbare Analogsignale verändert und “gebogen” werden, um ein Audio/Video-Rauschbild zu erzeugen, das wiederum eine zeitbasierte Skulptur erschafft. Mit “Soundform No.1” formen Yasuaki Kakehi (JP), Mikhail Mansion (US), Kuan-Ju Wu (US) eine minimalistische Klanglandschaft und kinetische Kunstinstallation aus Wärme, Licht und Bewegung.

Sonntag, 8. September 2019 / Donaupark, POSTCITY

Talks

In der POSTCITY eröffnet Roberto Viola (IT) von der Europäischen Kommission mit seinem Statement eine ganze Reihe von Talks. Christine Bauer von der JKU und Peter Knees von der TU Wien forschen zu „Music Information Retrieval“ und geben zunächst eine Einführung in das Gebiet und den Stand der Technik im Bereich der Musikinformationsbeschaffung. Philippe Esling (FR), Jérôme Nika (FR) und Daniele Ghisi (FR) sprechen über Forschungsprojekte des Institut de Recherche et Coordination Acoustique/Musique am Centre Pompidou in Paris (IRCAM), die auf Leistungsvermögen und Grenzen künstlicher neuronaler Netze fokussieren. Jérôme Nika wiederum nimmt genau dies zum Anlass, um eine Artificial General Intelligence (AGI) zu skizzieren, die mit ein und demselben Code eine Vielzahl ganz unterschiedlicher Probleme lösen könnte. Danach kommen Nick Bryan Kinns (UK) von der Queen Mary University, Koray Tahiroglu (FI) von der Aalto University, Ludger Brümmer (DE) vom ZKM. Im Anschluss folgt die Präsentation einer AI-Forschung mit François Pachet (FR) von Spotify, Vittorio Loreto (IT) von SonyLab und Akira Maezawa (JP) von Yamaha. Den Abschluss bilden dann die Start-Ups Amadeus Code, Endel, Fortunes und Music Traveller.

Workshops

Zeitgleich zu den Talks gibt es Workshops mit Ali Nikrang (IR/AT) vom Ars Electronica Futurelab, Alex Braga (IT) von „A-MINT“, Phillipe Esling (FR) von IRCAM sowie Gerald Wirth (AT) von den Wiener Sängerknaben und Vive Kumar (IN) von der Atabasca University.

Episode am Fluss

Sonntagabend ist das „AI x Music Festival“ im Donaupark zu Gast. Angelegt als eine „Episode am Fluss“ inszenieren Ars Electronica, Bruckner Orchester und Brucknerhaus eine Hommage an die allererste Klangwolke. Ausgangspunkt dieser Klangreise wird so wie schon 1979 das Orchesterkonzert im Großen Saal des Brucknerhauses sein, das nicht bloß nach außen auf die mächtige Soundanlage der Klangwolke übertragen wird, sondern das klangliche Ausgangsmaterial für Wolfgang „Fadi“ Dorninger (AT), Ali Nikrang (IR/AT), Roberto Paci Dalò (IT), Rupert Huber (AT), Markus Poschner (DE), Sam Auinger (AT) sowie Christian Fennesz (AT) und Lillevan (DE), die damit im Donaupark neue akustische, analoge und digitale Klangräume erschaffen.

Ausstellungen während des gesamten „AI x Music Festivals”

Ergänzend zu den Konzerten, Performances, Konferenzen, Lectures, Panels und Workshops sind das gesamte „AI x Music Festival“ über auch eine Reihe von Ausstellungen und Präsentationen zu erleben. GründerInnen, CEOs führender Unternehmen, ProtagonistInnen der alternativen Szene, WissenschaftlerInnen und KünstlerInnen präsentieren ihre Produkte, Prototypen und Projekte in der POSTCITY.

AUSSTELLUNG / KUNST

Domhnaill Hernon (IE), Leiter der Nokia Bell Labs und Künstler und Beatboxer Reeps One (UK) machen deutlich, dass es entgegen der öffentlichen Debatte bei der Entwicklung von AI-Systemen nicht darum geht, den Menschen zu ersetzen, sondern sinnvoll zu ergänzen und unterstützen – auch und vor allem in der Kreativwirtschaft.

Alex Bragas (IT) „A-MINT“ ist eine neue Art der adaptiven künstlichen musikalischen Intelligenz, die erstmals in der Lage ist, den Improvisationscode aller MusikerInnen in Echtzeit zu knacken und mit ihnen zu improvisieren – ohne voreingestellte Muster, Tonhöhe oder BPM entstehen während der Performance Musik und Videos.

Das gerade eben neueröffnete Ars Electronica Center wiederum zeigt gleich eine ganze Ausstellung zum Thema. „AI x Music“ zeichnet die Geschichte der Musik nach und damit jene der Instrumente, Werkzeuge und Apparate zu ihrer Aufführung, Aufzeichnung und Wiedergabe. Die Schau spannt einen Bogen von den ersten Saiten- und Blasinstrumenten der Antike bis zu den digitalen Synthesizern unserer Tage, von den Wachswalzen und rußbedeckten Glasplatten der ersten Vorläufer des Grammophons bis zu den digitalen Streaming Diensten des Internets. All das führt schließlich zu AI und Machine Learning und wieder neue Möglichkeiten der kreativen Gestaltung, die KünstlerInnen weltweit bereits zum Einsatz bringen. „AI x Music“ macht deutlich, dass es dabei nicht bloß um technologische Phänomene geht, sondern um grundlegende Fragen der Beziehung von Mensch und Maschine.

AUSSTELLUNG / INDUSTRIE, Start-Ups und etablierte Unternehmen

Mit „Music Traveler“ stellen Dominik Joelsohn (DE/AT), Aleksey Igudesman (DE/AT) und Julia Rhee (KR/US) eine Peer-to-Peer-Plattform vor, die MusikerInnen hilft, den nächsten verfügbaren Proberaum, das nächste Tonstudio und die nächste Konzerthalle schnell und einfach finden und buchen zu können.

Mit seinem „Amadeus Code“ präsentiert Taishi Fukuyama (JP) einen AI-basierten Assistenten für Songwriting. Die mobile App bietet schier unbegrenzte Inspiration zur Topline-Melodie über verschiedenen Akkordfolgen und erstellt Skizzen neuer Musikkompositionen.

Mit „Endel” präsentiert Oleg Stavitsky (RU) eine Technologie, die personalisierte Klänge erzeugt, um Stress abzubauen, den Fokus zu erhöhen und den Schlaf zu verbessern. Sämtliche Sounds werden dabei in Echtzeit generiert und von Standort, Zeit, Herz- und Trittfrequenz beeinflusst, die wiederum über das Smartphone erfasst werden.

„0W1 Audio“ von Jean Beauve (FR) ist ein Startup-Unternehmen der Musikbranche, das IoT-Audio-Plattformen entwickelt, die sich durch einen unglaublich natürlichen Klang auszeichnen.

AUSSTELLUNG / RESEARCH

Mathias Röder (DE) und das Karajan Institut treiben die Grenzen neuer Technologien bei der Kreation, Verbreitung und Rezeption von Musik ständig voran. Im Rahmen des „AI x Music Festivals“ berichtet er über den vom ihm initiierten „AI and Music Hackathon“ für junge Kreative und Tech-Freaks.

„Computers that Learn to Listen“ ist ein Video, das einige Ergebnisse der wissenschaftlichen Forschung zu KI und Musik zeigt, die am von Gerhard Widmer (AT) geleiteten Institut für Computational Perception der Johannes Kepler Universität Linz durchgeführt wird. Basierend auf den neuesten Fortschritten im Machine Learning lernen Computer, Musik zu „hören“ und zu „verstehen“, Takt und Rhythmus zu erkennen, Musikstücke aus wenigen gespielten Noten sofort zu identifizieren.

Koray Tahiroglu (FI/TR) von der Aalto University präsentiert „NOISA“ (Network of Intelligent Sonic Agents), ein AI-basiertes interaktives Musiksystem, dessen Klangagenten Musikperformances unterstützen. Jeder Schall-Agent verfügt dabei über ein maschinell lernendes Modell zur Vorhersage und Anpassung seines Verhaltens in der Performance.